一个简单的dht种子爬虫

文章目录

之前看了小虾的博客,他搭了一个种子搜索引擎,感觉很有意思,于是便萌生了学习一下如何抓取种子的方法的想法。

小虾的博客并没有很详细的介绍关于种子搜索方面的技术性的文章,网上找了一些相关的博客以及开源代码,链接如下:

- dht协议

- dht协议的中文翻译

- P2P中DHT网络爬虫

- 大白话讲解DHT原理及出现历史

- BitTorrent协议详解

- BitTorrent 协议规范(BT协议集合)

- 用Python教你如何“养”一只DHT爬虫

- 根据磁力链获得BT种子

在上面几篇文章中,最需要参考的是第2篇文章,当然英文好,可以直接看官方的(第一篇)。第3篇到第6篇是用来帮助理解官方文档的,第7篇有一些代码,用来帮助理解路由表的概念,第8篇用来进行后续种子获取方面的处理。

除了上面几篇文章介绍外,在github以及其他网站上也找了一些可以用来参考的代码,链接如下:

上述几个代码中,我主要看了第1、2、5个,这几个相对来讲比较简单,而这三个中,第一个最简单,第二个在第一个之上添加了一些路由表相关的东西,而第5个的路由表功能更加健全。第4个程序貌似是一位大神编写用来抓取整个互联网种子的程序(第三个程序的作者说的)。

在讲解爬虫之前,需要先了解一下dht协议,关于dht协议,官方网站已经讲的很齐全了,但是即使这样,在我最开始阅读的时候也还是遇到了一些困难,因此在这里,按照我的理解,更通俗的记录一下和爬虫相关的dht协议,方便今后自己查阅。

在dht网络当中,每个下载者的客户端(这个客户端同时也是一个服务端)都有一个节点标识自己的存在,这个节点有一个在整个dht网络当中唯一的节点ID(我认为会有重复的),这个节点ID是一个长度为160bit(20字节)的字串,除了节点ID,节点还包含有节点ip和节点端口。

作为一个客户端,它有几种方法,这几种方法在官方文档中进行了详细的讲解,而在这个简单的爬虫中需要的方法有:find_node,get_peers,announce_peer 。根据名字就可以知道这几个方法的具体作用。

find_node方法是请求方法,主要是用来查找给定ID的节点的联系信息。其需要的参数有,自身节点的ID,目标节点的ID。当使用该方法后,目标节点会回复相应的信息,回复的信息包含的信息有:一个是回复客户端的节点ID,一个是回复客户端的路由表中离目标节点最近的K(8)个节点的联系信息。在爬虫程序中,需要发送find_node请求,并接收目标节点的应答。

get_peers方法也是请求方法,主要是用来获取想要下载资源的节点的信息。它需要两个参数:一个是自身节点的ID,一个是infohash的信息(这个hash值对应着唯一的一个种子信息,可以通过这个hash值获取到与其对应的种子)。当使用该方法后,目标节点同样会回复相应的信息,具体信息查阅官方文档,在爬虫程序当中,不需要关心其回复的信息。在爬虫程序中,只需要接收别人发给我们的请求并获取到infohash即可,不需要进行回复。

announce_peer方法也是请求方法。当一个客户端开始下载某个torrent文件时,他就会向所有向他请求过的节点使用annouce_peer方法,及发送自身节点的ID,下载文件的hashinfo,下载使用的端口,以及token。当我们接收到announce_peer请求时,需要根据情况对其进行回复,但是作为爬虫,这个回复并不重要,我们需要关心的是接收到的infohash。这个infohash代表已经有客户端开始下载这个infohash对应的文件了,所以这个infohash肯定是有效的,而通过get_peers方法获取到的infohash是别的节点请求的,那么也就说明可能是死的。在爬虫程序中,也只需要接收别人发给我们的announce_peer请求即可,不要对其进行回复。

接下来说下爬虫的思路。通过上面三种方法的介绍,便知道我们的主要抓取对象便是infohash,我们需要尽可能的抓取infohash,而infohash是和get_peers与announce_peer方法相关的,所以,如果我们想要尽可能多的获取到infohash就需要尽可能多的节点。而获取节点就需要使用find_node方法。

在使用find_node方法之前,我们需要加入到dht网络当中。如何加入dht网络呢?我们可以向网络上那些公共的节点发送find_node请求,这样,那些公共节点就会给我们回复一些节点的信息,这样我们就可以获取到一些节点,然后我们继续对获取到的这些节点发送find_node请求,从而认识更多的节点。当认识这些节点后,这些节点也会认识我们自身,所以这些节点在调用get_peers方法和announce_peer方法时,就会发送通知给我们,而我们接收到这些信息后,就可以把这些infohash记录下来。然后循环这个过程,我们就可以不断的获取到很多infohash。

关于dht协议中提到的路由表,在这个简单的爬虫里面根本就没有用到,只是用了一个简单的队列代替了,如果想看路由表的一些简单实现,可以上面列的代码5。代码3、4我没有看,不清楚有没有实现路由表相关的部分。

接下来是程序,程序几乎和simDHT程序一模一样,我只是稍微改动了一些东西,另外,我会配上注释。感谢作者开源。

程序运行需要安装 bencode 库。

|

|

这段代码非常简单,我运行测试了一下,速度勉强还可以,之前在网上看一些人的抓取速度是三天100万,还有的是三天150万,速度非常恐怖,这个简单的爬虫怕是达不到要求了。之前在vps上测试了一下,速度非常快,但是因为爬虫占用流量非常大,所以没敢在vps上长期运行,怕vps被封了。另外,这个程序是单线程的,可以根据情况改成多线程的。

抓取完之后,hash值会存储下来,但是这些hash值中有很多重复的,因此接下要做的就是去重。使用python的set类型可以非常方便的进行去重。

去重代码如下:

|

|

去重之后,如果想要获取这些hash值所对应的种子的信息,可以把这些hash值换成相应的磁力链接,关于hash值如何换算成磁力链接的方法在最上面的第8篇博文中已经讲解了。将hash值改成磁力链接后,可以把磁力链接粘贴到迅雷中,然后由迅雷下载种子,然后再进行相关文件的下载。

但是实际上,上述方法非常费时费力,而且之前抓取的hash值当中有很多是无效的。为此,还是写一个脚本验证比较好。我根据这篇Python开发实例分享bt种子爬虫程序和种子解析文章的代码重新写了一段分析代码,代码如下:

|

|

该程序还是单线程的,当然改成多线程的也是相当方便的。

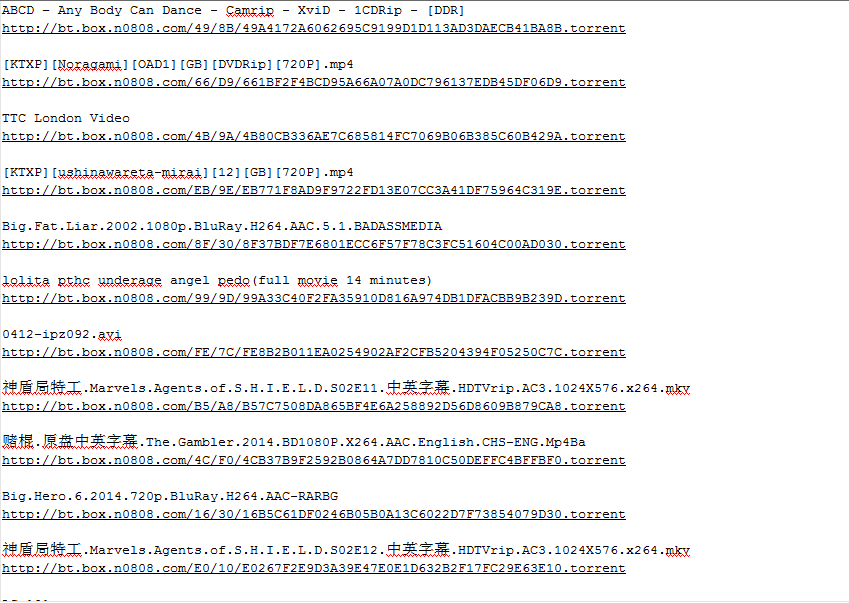

下图是处理后的结果。

整体来说,算是知道dht种子爬虫的大致原理了,但这只是很浅的东西,如果想要写出更加快速,hash值准确度更高的程序的话,还是需要了解更多东西的。

最后,最近又看到一片文章:Node.js 去掉种子(torrent)文件里的邪恶信息,看完之后,我邪恶的笑了。我根据这篇文章又写了一个python版本的程序(不会js),程序如下:

|

|

当成功把种子信息修改之后,发现这个东西不太好用。同一个种子(有不健康信息的种子),在不修改文件名的情况下,纵然无法使用某雷的极速下载,但速度还是相当可观的,最起码能找到资源。但是当修改文件名之后,就发现某雷找不到资源了,这没资源还怎么下。。。。对于为什么某雷在种子内的文件信息修改之后无法快速的找到资源这一情况感到很是困惑。

后来,事情似乎出现了转机,我尝试了作者下载文件的方法,使用某云的离线下载,我昨天晚上把种子上传上去,今天晚上打开发现文件已经下载到云空间了。具体是什么时候下载完成的并不清楚,但是某云确实给下载下来了,但是当我从云端下载到本地的时候,某云就警告我说这是违规内容,无法下载到本地。对于此,我是感到非常无奈。